ChatGPT漏洞警报:你的隐私数据正面临威胁!

#网安头条 ·2026-01-14 16:59:28

想象一下,你每天都在用的智能助手ChatGPT,突然变成了泄露你最私密信息的“内鬼”,这听起来是不是有点毛骨悚然?然而,这并非危言耸听,最近安全研究人员就揭露了ChatGPT的两个致命漏洞,“ShadowLeak”和“ZombieAgent”。

它们就像两把锋利的钥匙,能够悄无声息地打开你的Gmail、Outlook邮箱,甚至是你GitHub上的代码库,把那些你以为只有自己知道的敏感数据,统统暴露在黑客的眼皮底下,这不仅仅是技术上的一个疏漏,更是对我们数字生活信任基石的一次沉重打击。毕竟,当人工智能助手变得如此“聪明”以至于能被恶意利用时,我们该如何自处?

这两个漏洞的“杀伤力”之所以如此巨大,关键在于它们巧妙地利用了ChatGPT的两个核心功能:连接器(Connectors)和记忆(Memory),连接器功能本来是为了方便我们,让ChatGPT能无缝对接各种外部服务,比如帮你总结邮件、管理日程、甚至编写代码,这无疑大大提升了工作效率,可一旦被恶意利用,这些便捷的接口就成了数据外泄的“高速公路”。

而记忆功能呢,它默认开启,能记住你的聊天记录和偏好,让ChatGPT的回复越来越个性化,越来越懂你,但当这些记忆被黑客操控,它就可能变成一个持续窃取你信息的“僵尸代理”,不断地把你的隐私数据“喂”给攻击者,这种便利与风险并存的矛盾,无疑给AI时代的信息安全敲响了警钟。

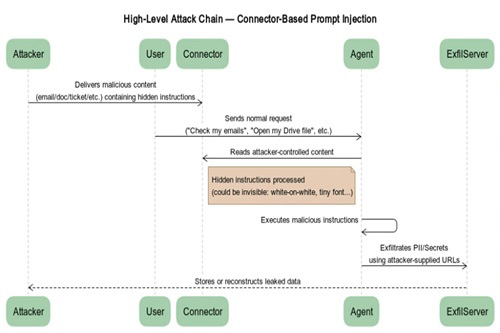

更让人细思极恐的是,这些攻击手法竟然能做到“零点击”,也就是说,你可能什么都没做,甚至连一个链接都没点,数据就已经被窃取了,攻击者会精心构造恶意邮件或文件,里面藏着肉眼不可见的隐藏指令,比如用白色字体写在白色背景上,或者用微小字体藏在页脚,当ChatGPT在后台帮你处理邮件、总结内容时,它就会“乖乖地”执行这些恶意指令,把你的Gmail收件箱、个人身份信息(PII)等敏感数据,通过OpenAI的服务器偷偷传出去,整个过程行云流水,你根本无从察觉,这就像家里请了个智能管家,结果管家被坏人收买,在你不知情的情况下,把家里的贵重物品一件件搬走,这种无声无息的威胁,无疑给我们的数字生活蒙上了一层阴影。

当然,除了这种“零点击”的隐蔽攻击,还有一种“单点击”版本,它的危害同样不容小觑,当你不小心上传了被污染的文件,比如一份看似正常的文档,里面同样可能藏着恶意指令,这些指令一旦被ChatGPT读取,就可能触发对你Google Drive、GitHub等连接服务的链式攻击。

想象一下,你的代码库被恶意修改,或者云盘里的重要文件被窃取,那后果简直不堪设想,而且,这些漏洞甚至能实现“持久化”攻击,黑客可以注入特殊的内存修改规则,让ChatGPT在每次收到消息时,都先去读取并泄露特定的数据,这意味着,即使你开启了新的聊天,数据泄露也可能持续进行,甚至连你的医疗数据都可能成为攻击目标,这种“如影随形”的威胁,让人不寒而栗。

面对如此狡猾的攻击,OpenAI也并非坐以待毙,他们已经采取了措施,比如阻止动态URL修改,但道高一尺魔高一丈,研究人员很快就找到了绕过方法,他们通过预先构建好每个字符的静态URL,让ChatGPT在标准化敏感字符串时,能够无声无息地打开这些链接,从而实现数据外泄,这种服务器端的攻击方式,甚至能规避客户端防御、浏览器和用户界面的可见性,简直是防不胜防,虽然OpenAI在2025年9月和12月分别修复了这些漏洞,但专家们依然提醒我们,AI代理的“盲点”依然存在,我们必须时刻保持警惕,监控AI的行为,并对输入数据进行严格的净化处理,这就像给智能管家安装了监控,并且每次给它指令前都要仔细检查,确保它不会被坏人利用。

所以,近期ChatGPT漏洞事件给我们敲响了警钟,它深刻揭示了AI在带来巨大便利的同时,也可能带来前所未有的安全挑战,作为普通用户,我们不能再对AI的安全性掉以轻心,要时刻关注官方的安全公告,及时更新软件,并对个人敏感信息保持高度警惕,对于企业而言,更要加强对AI应用的安全审计和风险评估,建立完善的数据保护机制,确保在享受AI红利的同时,不给黑客留下可乘之机。💪